【導讀】自大數據問世以來,用于超大規模數據中心、人工智能(AI)和網絡應用的片上系統(SoC)設計人員正面臨著不斷演進的挑戰。由于工作量的需求以及需要更快地移動數據,具有先進功能的此類SoC變得益發復雜,且達到了最大掩模版(reticle)尺寸。本文介紹了die-to-die連接的幾種不同用例,以及在尋找用于die-to-die鏈接的高速PHY IP時要考慮的基本注意事項。

自大數據問世以來,用于超大規模數據中心、人工智能(AI)和網絡應用的片上系統(SoC)設計人員正面臨著不斷演進的挑戰。由于工作量的需求以及需要更快地移動數據,具有先進功能的此類SoC變得益發復雜,且達到了最大掩模版(reticle)尺寸。因此,設計人員將SoC劃分為多芯片模塊(MCM)封裝的較小模塊。這些分離的芯片需要超短(ultra-short)和極短(extra-short)距離鏈接,以實現具有高數據速率的die間連接。除帶寬外,裸片到裸片(die-to-die)的連接還必須確保是極低延遲和極低功耗的可靠鏈接。本文介紹了die-to-die連接的幾種不同用例,以及在尋找用于die-to-die鏈接的高速PHY IP時要考慮的基本注意事項。

Die-to-die連接用例

MCM中die-to-die連接的新用例正在出現,其中一些包括:

高性能計算和服務器SoC接近最大掩模版尺寸

以太網交換機和網絡SoC超過最大掩模版尺寸

可擴展復雜算法的具有分布式SRAM的人工智能(AI)SoC

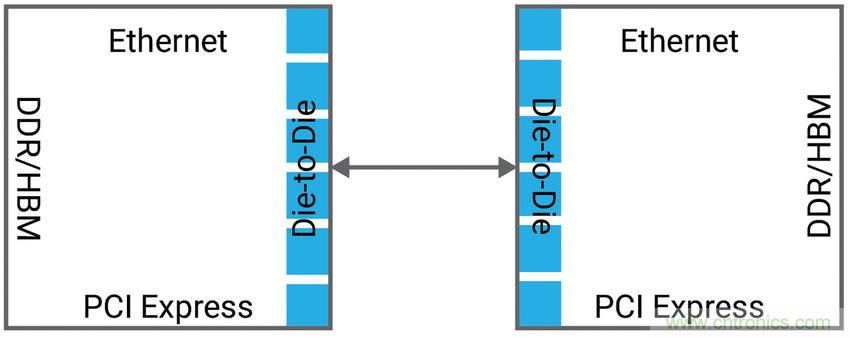

高性能計算和服務器SoC的面積正變得越來越大,達到550 mm2至800 mm2,從而降低了SoC的良率并增加了每個Die的成本。優化SoC良率的更好方法是將SoC分為兩個或多個相等的同質die(如圖1所示),并使用 die間PHY IP連接 die。在這種用例中,關鍵的要求是極低延遲和零誤碼率,因為更小的多個 die的表述和表現必須像單一die一樣。

圖1:需要die-to-die連接的高性能計算和服務器SoC示例

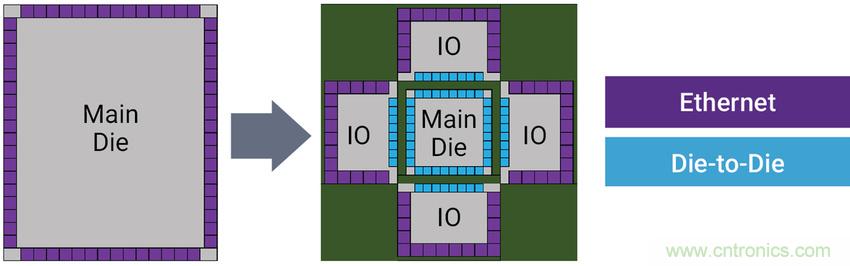

以太網交換機SoC是數據中心的核心,必須以快于12Tbps到25Tbps的速率傳送數據,這需要256個通道的100G SerDes接口,因此無法將這種SoC裝入800 mm2大小的掩模版。為克服這一挑戰,設計人員將SoC拆分為這樣一種配置:其中,內核die被I/O die包圍,如圖2所示。然后,使用Die-to-die收發器將內核die連接到I/O die。

在這種用例中,僅當die-to-die收發器的帶寬密度遠優于I/O die中的長距離SerDes時, die拆分才有效用。因此,關鍵參數是每毫米的die邊緣(die-edge)帶寬密度。

圖2:需要die-to-die連接的以太網交換機SoC示例

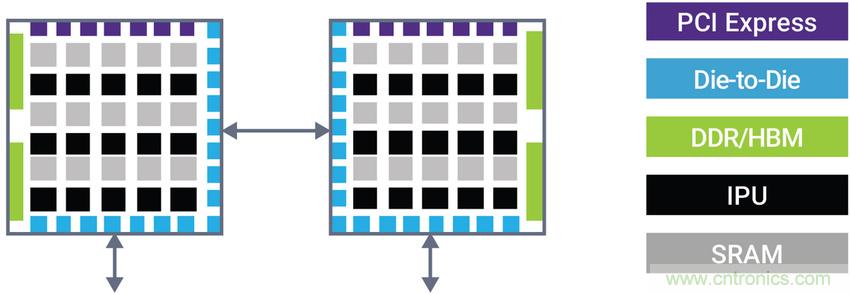

在一款AI SoC中,每個die都包含智能處理單元(IPU)和位于每個IPU附近的分布式SRAM。在這種用例下,一個die中的IPU可能需要依賴于極低延遲的短距離die-to-die鏈接來訪問另一die中SRAM內的數據。

圖3:需要die-to-die連接的AI SoC示例

在所有這些用例中,用于die-to-die連接的理想高速PHY可以簡化MCM封裝要求。由于每個通道的吞吐量高達112 Gbps,因此在通道數量相對有限的情況下可實現非常高的總吞吐量。在這種情況下,封裝走線間距和堆疊可能比較保守(L /S通常為10u /10u)。在這些用例中,也可以使用傳統、低成本、基于有機基材料的封裝。

Die-to-die連接的高速PHY IP要求

光互聯論壇(OIF)正在定義電氣I/O標準,以在超短距離(USR)和極短距離(XSR)鏈路上以高達112Gbps的數據速率傳輸數據。這些規范定義了die-to-die的鏈接(即:封裝內)以及die-to-die到與該SoC位于同一封裝內的光學引擎的鏈接,從而顯著降低了功耗和復雜性,并實現了極高的吞吐量密度。

在研究用于MCM中的die-to-die連接的高速PHY IP方案時,SoC設計人員必須考慮幾個基本功能,包括:以千兆位或兆兆位每秒(Gbps或Tbps)度量的數據吞吐量或帶寬;以每比特皮焦耳(pJ/bit)為單位檢視的能源效率;以納秒(ns)為單位測量的延遲;以毫米(mm)為單位表度的最遠鏈接距離;以及誤碼率(無單位)。

數據吞吐量或帶寬

為了實現與其它收發器的互操作性, die-to-die PHY IP必須確保符合USR和XSR鏈路的相關OIF電氣規范。支持脈沖幅度調制(PAM-4)和不歸零(NRZ)信令對于滿足兩種鏈路的要求并實現每通道最大112Gbps帶寬至關重要。這種信令支持非常高的帶寬效率,因為在MCM中的die之間傳輸的數據量非常大,因此帶寬效率是至關重要的要求。數據移動速率通常在每秒兆兆位水平,這就限制了分配給USR和XSR鏈路的芯片邊緣(前端/ beach front)的大小。

但是,同樣重要的是支持多種數據速率。通常,期望在假設其數據速率與內部建構數據速率相匹適或支持chip-tp-chip協議所需的所有數據速率的條件下,實現die-to-die的鏈接。例如,即使在諸如32Gbps這樣的高速下,PCI Express也必須支持低至2.5Gbps的數據速率以進行協議初始化。

鏈接距離

在die-to-die的實現中,大量數據必須流經橋接die間間隙的短數據路徑。為保證將die放置在封裝基板上時的最大靈活性,PHY IP必須支持TX和RX之間50mm的最長距離。

能效

能效成為重要的因素,尤其是在將SoC功能劃分為多個同質die的用例中。在這種情況下,設計人員尋求在不影響SoC總功耗預算的情況下在die之間推送大量數據的方法。理想的die-to-die PHY IP的能效應好于每比特1皮焦耳(1pJ/bit)或等效的1mW/Gbps。

延遲和誤碼率

為了使die之間的連接“透明”,延遲必須極其低,同時必須優化誤碼率(BER)。由于采用了簡化的架構, die-to-die PHY IP本身可實現超低延遲,而BER優于10e-15。根據鏈路距離,可能需采用前向糾錯(FEC)機制保護互連,以實現如此低的BER。 FEC延遲會影響方案的整體延遲。

Macro 擺放

除了這些與性能相關的參數外,PHY IP還必須支持在die所有位向的放置,以實現die以及MCM的高效平面規劃。宏(macro)的優化布局可實現低耦合的高效die間布線、優化的die和MCM大小、并最終提高能效。

選擇die-to-die的PHY IP時,還有許多其它考慮因素,包括整合進可測試性功能,以便能夠在封裝之前對die進行生產測試,但前述幾點是最重要的。

結論

更高的數據速率和更復雜的功能正在增加用于超大規模數據中心、AI和網絡應用的SoC的大小。隨著SoC尺寸接近掩模版尺寸,設計人員被迫將SoC分成較小的die,這些die封裝在多芯片模塊(MCM)中,以實現高良率并降低總體成本。然后,MCM中的較小die通過die-to-die互連進行鏈接,這些互連具有極低功耗和 而且每個die邊緣都具有高帶寬。在高性能計算和AI應用中,大的SoC被分為兩或多個同質die;在網絡應用中,I/O和互連內核被分為單獨的die。這種SoC中, die-to-die的互連必須不影響整體系統性能,并且要求低延遲、低功耗和高吞吐量。這些要求推動了對諸如Synopsys的DesignWare®USR/XSR PHY IP這樣的高吞吐量die-to-die PHY的需求,該IP支持MCM設計中的die-to-die鏈接,每通道的數據速率高達112Gbps,且能效極高。DesignWare USR/XSR PHY IP符合用于USR和XSR鏈接的OIF CEI-112G和CEI-56G標準。

免責聲明:本文為轉載文章,轉載此文目的在于傳遞更多信息,版權歸原作者所有。本文所用視頻、圖片、文字如涉及作品版權問題,請聯系小編進行處理。